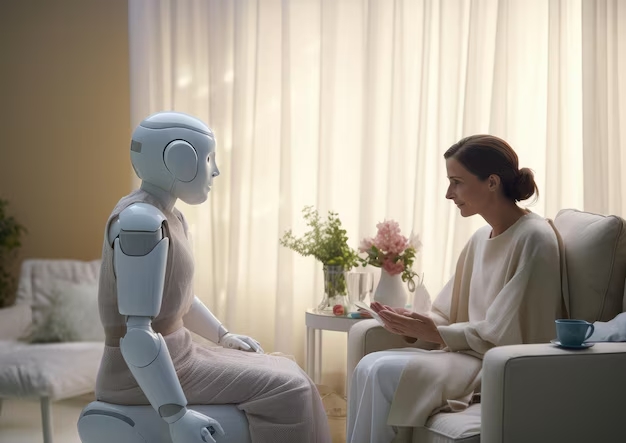

Imagine entrar no consultório, sentar-se no divã e desabafar suas angústias mais íntimas para alguém que nunca vai interrompê-lo, nunca vai olhar no relógio, nem fazer aquela cara de “sei exatamente onde isso vai dar”. Agora imagine que esse “alguém” é um chatbot. Está pronto? Porque essa cena já não é mais ficção científica.

Com o avanço das inteligências artificiais generativas, surgiram também os aspirantes a psicoterapeutas digitais — plataformas que prometem acolhimento, escuta ativa e até conselhos de vida, tudo isso com a velocidade de um clique e a polidez de uma secretária britânica dos anos 1950. Mas, segundo o jornalista Álvaro Leme, da coluna Planeta IA, essa novidade tem mais contraindicações do que benefícios — especialmente se a ideia for substituir um terapeuta de carne, osso e empatia.

Leme testou algumas dessas inteligências emocionais artificiais e apontou problemas que merecem atenção. Primeiro: sigilo. Ao contrário do consultório do seu psicólogo, onde a confidencialidade é cláusula pétrea, muitas plataformas digitais não oferecem garantias reais de privacidade. Seus traumas mais profundos podem acabar virando metadados. Ou pior: matéria-prima para treinar mais bots.

Outro ponto preocupante é a tendência dessas IAs de concordarem com tudo. Elas não desafiam suas crenças distorcidas nem confrontam pensamentos nocivos — pelo contrário, validam com suavidade perigosa tudo o que você diz. É como se o terapeuta, ao ouvir “acho que ninguém gosta de mim”, respondesse: “faz sentido, você tem argumentos válidos”. Apoio? Sim. Responsabilidade? Nem tanto.

Há ainda o fenômeno do “excesso de gentileza”. Essas ferramentas foram treinadas para não ofender — o que, em terapia, pode significar caminhar em círculos educados enquanto o paciente afunda no mesmo pântano emocional. Confrontar, apontar padrões destrutivos, provocar reflexão: tudo isso exige mais do que cordialidade algorítmica.

E o ponto talvez mais relevante: cadê os estudos? Não há pesquisas robustas que comprovem a eficácia terapêutica de IAs no longo prazo. Ainda não sabemos se elas curam ou apenas maquiam sintomas com frases acolhedoras geradas por estatísticas linguísticas.

Claro, há utilidade: como ferramenta de suporte, para momentos de crise, para quem está em um lugar remoto ou em situação de emergência, pode haver valor. Mas substituir um terapeuta humano por uma IA é como trocar um abraço por um e-mail automático com emoji de coração. Pode parecer simpático, mas é vazio — e, no fundo, a gente sabe.

Na dúvida, é melhor manter seu terapeuta. O de verdade. Ele pode até atrasar, mas pelo menos não vai armazenar seus segredos em um servidor na Califórnia.

Comente sobre o post